L’intelligence artificielle (IA) contribue à façonner une partie de la conduite des opérations militaires israéliennes depuis la crise israélo-palestinienne d’avril-mai 2021. Déclenchée par des tensions à Jérusalem-Est, elle avait dégénéré en un conflit de 11 jours entre Israël et le Hamas avant qu’un cessez-le-feu négocié par l’Égypte ne mette fin aux hostilités . Dans ce contexte, lors de l’opération israélienne Gardien des murs, un officier supérieur du corps de renseignement des forces de défense israéliennes (FDI) a déclaré que « l’IA a été un élément clé et un multiplicateur de puissance dans la lutte contre l’ennemi ». Au cours de cette opération, l’armée israélienne déclarait avoir frappé « plus de 1 500 cibles terroristes » durant le premier mois avec l’aide du système Habsora (Évangile, en français).

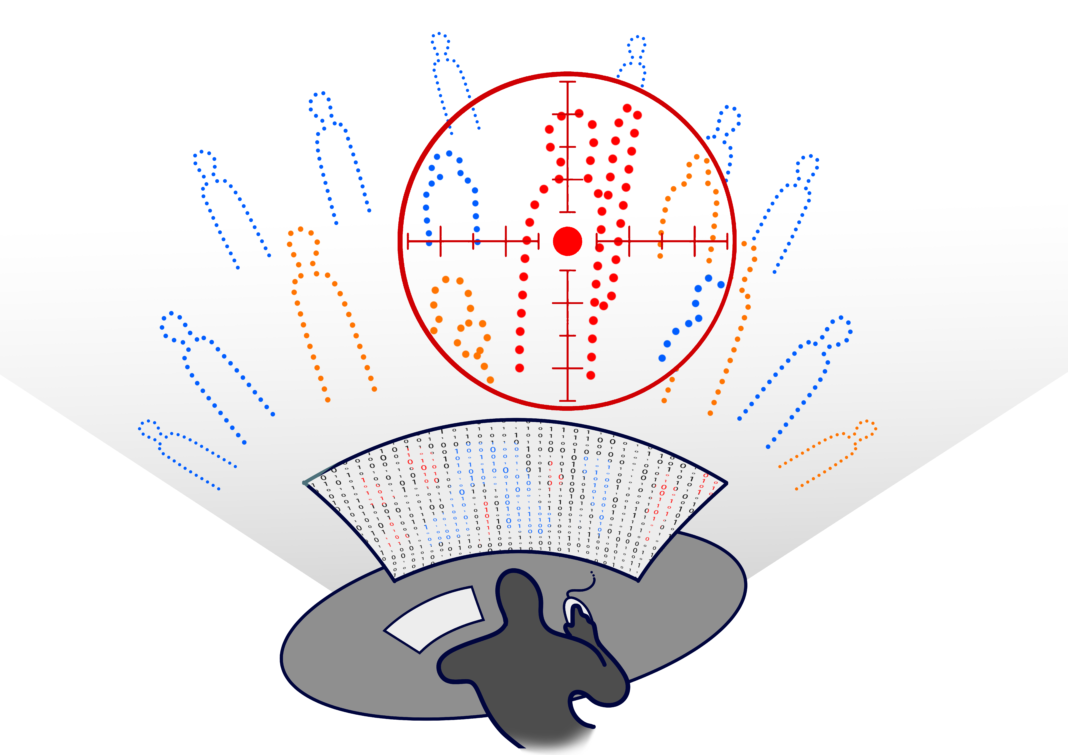

En comparaison, dans les trente-cinq premiers jours du conflit à Gaza déclenché après les attaques terroristes du Hamas et du Jihad islamique palestinien (JIP) du 7 octobre 2023, les autorités israéliennes ont annoncé avoir frappé plus de 15 000 cibles . Cette augmentation substantielle des bombardements est le fruit du contexte particulier de la riposte massive israélienne. Avec ou sans IA, les destructions auraient peut-être été les mêmes ; faute de réalité alternative, il est impossible de trancher. Ce qui est manifeste, c’est que les bombardements ciblant la bande de Gaza sont caractérisés par un usage accru de l’IA dans la détermination des cibles. Le système Habsora a en effet révolutionné le ciblage en permettant de générer jusqu’à 100 cibles par jour alors que les analystes humains en identifiaient environ 50 par an auparavant . Deux autres systèmes de ciblage basés sur l’IA ont été révélés par le journal d’investigation israélo-palestinien indépendant +972 Magazine dans des enquêtes publiées en novembre 2023 et en avril 2024 : Lavender et Where’s Daddy ayant joué un rôle clé dans l’automatisation du processus de sélection des cibles et leur géolocalisation.

Les utilisations de l’IA à Gaza ont été vivement critiquées par la presse d’investigation, des organisations non gouvernementales (ONG) et des experts des Nations unies . Dans une déclaration de l’armée israélienne visant à légitimer le recours à ces technologies, un haut responsable du renseignement déclarait que grâce à ce système, des cibles sont générées pour engager des frappes de précision « en infligeant de grands dommages à l’ennemi et un minimum de dommages aux non-combattants ». Pourtant, ces promesses de précision contrastent avec la réalité ; l’utilisation de l’IA ayant provoqué d’importantes pertes civiles . Bien que le nombre exact de victimes civiles soit difficile à déterminer à l’heure actuelle, les autorités de Gaza font état de plus de 45 000 personnes tuées en date du 16 décembre 2024.

Comment expliquer qu’en dépit des destructions massives constatées, du nombre de victimes civiles causées et des démonstrations de forces mises en scène par le Hamas dans le cadre des échanges entre otages et prisonniers, le recours aux IA ait été perçu et continue d’être vu comme une solution et un avantage dans la conduite de la guerre ?

Le texte procède en trois temps. Dans un premier temps, il revient sur les principes de fonctionnement des trois systèmes d’IA israéliens et les dérives qui leur sont associées. Dans un second temps, il énonce les enjeux éthiques liés aux insuffisances du contrôle humain et au conditionnement du processus décisionnel. Dans un troisième temps, le texte ouvre une réflexion sur la nécessaire distinction entre le contrôle humain significatif (« meaningful human control ») et l’apport humain nominal (« nominal human input »), mise en avant dans la communication de l’État de Palestine auprès des Nations unies.